IA não consegue deduzir seus desejos e pensamentos (ainda)

Redação do Diário da Saúde

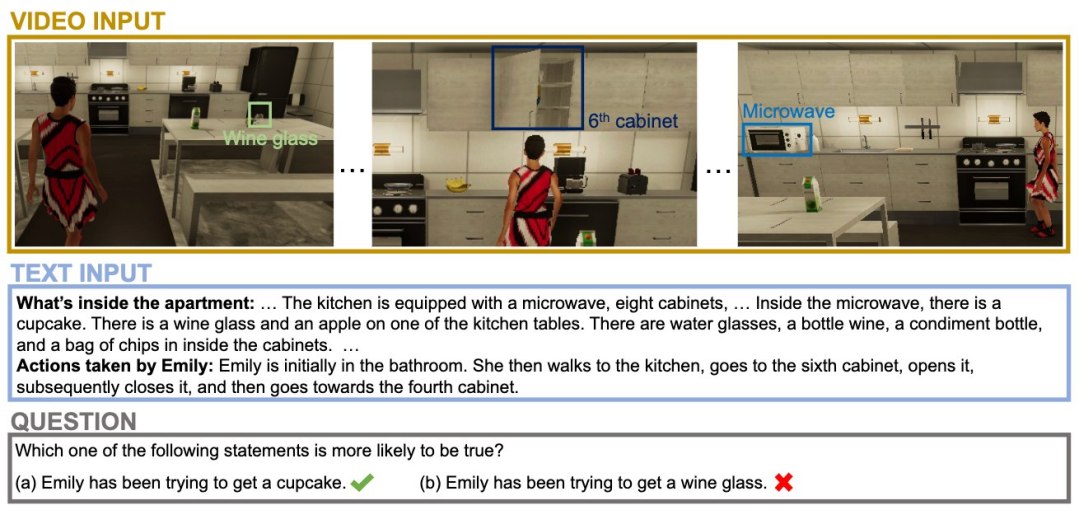

[Imagem: MMToM Project]

Ler nas entrelinhas

Escreva um comando claro e lógico e você poderá até obter uma boa resposta de um programa de inteligência artificial. Mas não irá além disso.

Chuanyang Jin e colegas da Universidade Johns Hopkins (EUA) constataram que os programas de inteligência artificial mais populares não conseguem perceber os desejos e objetivos que não estão claramente descritos, o que é muito diferente da interação entre humanos, onde desejos e objetivos não expressos são facilmente detectados pelas partes e influenciam na interação.

Como criaturas inerentemente sociais, os humanos podem inferir as emoções e os estados mentais uns dos outros a partir de uma série de fontes: Observando suas ações e gestos, ouvindo suas conversas, aprendendo com seus comportamentos passados e assim por diante. Pesquisadores cognitivos chamam isso de "Teoria da Mente", a capacidade de atribuir estados mentais ocultos, como objetivos, crenças e desejos, a outros indivíduos com base no comportamento deles.

"Entender o que os outros estão pensando ou sentindo é crucial para desenvolver máquinas que possam interagir com as pessoas de uma forma socialmente inteligente," contextualizou o professor Tianmin Shu, coordenador da pesquisa. "Por exemplo, um robô doméstico precisa dessa habilidade para descobrir o que alguém pode querer ou precisar para que possa ajudá-lo de forma mais eficaz na vida cotidiana."

Situações do mundo real

Em vez de tentar compor prompts de comando projetados para agradar os programas de inteligência artificial, a equipe criou o primeiro conjunto de dados padronizado que reflete as verdadeiras complexidades das tarefas de raciocínio encontradas por sistemas de IA do mundo real, como assistentes de IA e robôs cuidadores. Isso inclui coisas como vídeos e descrições de texto de pessoas procurando por objetos comuns em um ambiente doméstico, por exemplo.

Os pesquisadores testaram tanto humanos quanto modelos multimodais e de linguagem de última geração, para avaliar a capacidade de cada um para prever quais objetos as pessoas nos vídeos queriam encontrar e onde acreditavam que os encontrariam.

A equipe descobriu que os humanos foram melhores em entender os pensamentos e intenções dos outros quando tinham acesso a fontes variadas de informação. Em contraste, até mesmo os modelos de IA mais avançados - como o GPT-4V da OpenAI - tiveram problemas com tais tarefas, muitas vezes confundindo o que estava realmente acontecendo com o que uma pessoa acreditava estar acontecendo e tendo dificuldade em rastrear mudanças nos pensamentos das pessoas ao longo do tempo.

Ou seja, ao menos por enquanto, a IA não é boa em ler nas entrelinhas e menos ainda para detectar intenções humanas.

"Nossa pesquisa destaca falhas importantes nos modelos atuais de IA e sugere maneiras promissoras de melhorá-los," disse Shu. "Ao compartilhar esses insights, pretendemos ajudar outros a criar modelos de IA que possam entender melhor e trabalhar junto com as pessoas, levando, em última análise, a máquinas que realmente coloquem os humanos no centro de seu projeto."

Artigo: MMToM-QA: Multimodal Theory of Mind Question Answering

Autores: Chuanyang Jin, Yutong Wu, Jing Cao, Jiannan Xiang, Yen-Ling Kuo, Zhiting Hu, Tomer D. Ullman, Antonio Torralba, Joshua B. Tenenbaum, Tianmin Shu

Publicação: Proceedings of th 62nd Annual Meeting of the Association for Computational Linguistics

| Ver mais notícias sobre os temas: | |||

Softwares | Relacionamentos | Emoções | |

| Ver todos os temas >> | |||

Fitoterápico chinês trata demência e ainda rejuvenesce cobaias

O que ficar de pé sobre uma perna só diz sobre sua idade

Atualizadas recomendações médicas para prevenir derrame (AVC)

Homens e mulheres processam a dor de forma diferente

Excesso de consumo de energéticos pode levar a transtornos psíquicos

Microbiota intestinal: Microrganismos influenciam o corpo e a mente

Estudo revela ligações entre vários pesticidas e câncer de próstata

Nosso cérebro vê frases curtas como se elas fossem imagens

Pressão alta também causa enrijecimento dos pulmões

Caminhar dando arrancadas rápidas consome de 20% a 60% mais energia

IA não consegue deduzir seus desejos e pensamentos (ainda)

Mídias Sociais: Pessoas interagem mais em postagens com as quais discordam

Usamos as opiniões dos outros, mas apenas se pouparem trabalho

Nossas memórias não ficam apenas nos nossos neurônios

Pessoas com menos recursos são vistas como menos confiáveis - mesmo por outras pessoas pobres

Exercícios moderados já reduzem risco de doenças cardíacas - mas mais é melhor

Implantes são esterilizados dentro do corpo usando luz e nanopartículas

Biochip detecta cânceres em uma hora

Nosso cérebro vê frases curtas como se elas fossem imagens

Curativo bioeletrônico combate infecções sem usar antibióticos

Vacina do Butantan contra dengue grave tem 89% de proteção

Brasil tem primeiras mortes por febre oropouche no mundo

Censo 2022: Por que várias cidades brasileiras tiveram diminuição da população?

Brasil tem primeiro caso de gripe aviária em aves domésticas

Brasil decreta emergência zoossanitária devido à gripe aviária

Proibido o uso de animais em pesquisas de cosméticos e higiene pessoal

A informação disponível neste site é estritamente jornalística, não substituindo o parecer médico profissional. Sempre consulte o seu médico sobre qualquer assunto relativo à sua saúde e aos seus tratamentos e medicamentos.

Copyright 2006-2024 www.diariodasaude.com.br. Todos os direitos reservados para os respectivos detentores das marcas. Reprodução proibida.