Inteligência artificial mostra preconceitos: veja 5 exemplos

Com informações da New Scientist

[Imagem: New Scientist]

Riscos da inteligência artificial

A vida moderna já está largamente baseada em algoritmos de computador. Os programas coletores de dados que marcam a revolução da inteligência artificial já determinam os resultados das pesquisas do Google, as listas de notícias do Facebook e as recomendações de compras on-line.

E eles estão decidindo cada vez mais, incluindo se você irá receber um financiamento no banco, se será chamado para uma entrevista de emprego, as chances de você ser parado em um comando da polícia e, em alguns locais, até a sentença que enfrentaremos se acaso cometermos um crime.

Então eles devem ser inquestionáveis em sua capacidade de tomada de decisão, certo? Errado.

Dados distorcidos, lógica falsa ou apenas os preconceitos dos seus programadores significam que os programas de inteligência artificial com facilidade reproduzem - e até amplificam - os vieses humanos.

É o que mostram os cinco exemplos a seguir.

1. Prenda-os e jogue a chave fora

O COMPAS é um algoritmo amplamente usado nos EUA para orientar a sentença de condenados com base na previsão da probabilidade de uma reincidência criminal. Naquele que talvez seja o caso mais notório de preconceito da inteligência artificial, em maio de 2016, a organização de notícias ProPublica descobriu que o COMPAS é racialmente tendencioso. De acordo com a análise, o sistema prevê que os réus negros representam um risco maior de reincidência do que eles de fato praticam, acontecendo exatamente o inverso para os réus brancos. Equivant, a empresa que desenvolveu o software, contesta isso.

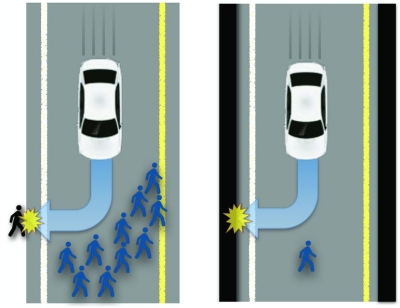

2. A minoria criminosa

Já em uso em vários estados dos EUA, o PredPol é um algoritmo projetado para prever quando e onde os crimes ocorrerão, com o objetivo de ajudar a reduzir o viés humano no policiamento. Mas, em 2016, o Human Rights Data Analysis Group descobriu que o programa pode levar a polícia injustamente para certos bairros. Quando os pesquisadores aplicaram uma simulação do algoritmo PredPol às ocorrências de drogas em Oakland, uma cidade de alta taxa de violência na Califórnia, o programa enviou repetidamente policiais a bairros com uma alta proporção de pessoas de minorias raciais, independentemente da verdadeira taxa de criminalidade nessas áreas.

Em resposta, o presidente da PredPol destacou que os dados de crimes envolvendo drogas não atendem ao limite de objetividade da empresa, e assim, no mundo real, o programa não é usado para prever crimes relacionados a drogas, a fim de evitar preconceitos. Mesmo assim, no ano passado, Suresh Venkatasubramanian e seus colegas da Universidade de Utah demonstraram que, como o programa aprende com as taxas de detenção, e não com a criminalidade, o PredPol cria um "ciclo de feedback" que pode exacerbar os preconceitos raciais.

[Imagem: Bonnefon et al. - 10.1126/science.aaf2654]

3. Eu vejo você, homem branco

Os programas de reconhecimento facial estão sendo cada vez mais usados na aplicação da lei - e são outra fonte potencial de viés de raça e gênero. Em fevereiro deste ano, Joy Buolamwini, do Instituto de Tecnologia de Massachusetts, descobriu que três dos programas mais recentes de inteligência artificial para reconhecimento de gênero, da IBM, Microsoft e da chinesa Megvii, conseguiram identificar corretamente o sexo de uma pessoa 99% do tempo, mas apenas para homens brancos. Para as mulheres de pele escura, a precisão caiu para apenas 35%.

Isso aumenta o risco de falsas identificações de mulheres e minorias. Novamente, provavelmente tem a ver com os dados usados para treinar o algoritmo: se ele contém muito mais homens brancos do que mulheres negras, ele será melhor em identificar homens brancos. A IBM anunciou rapidamente que havia retreinado seu sistema com um novo conjunto de dados, e a Microsoft afirmou que tomou medidas para melhorar a precisão.

4. Procura-se executivo-chefe: Apenas homens devem se inscrever

Um estudo de 2015 mostrou que, em uma pesquisa de imagens do Google por "CEO" - executivo chefe de uma empresa -, apenas 11% das pessoas exibidas eram mulheres, embora 27% dos executivos-chefes nos EUA sejam mulheres. Poucos meses depois, um estudo separado feito por Anupam Datta, da Universidade Carnegie Mellon, descobriu que o sistema de publicidade on-line do Google mostrava empregos de alta renda para os homens com muito mais frequência do que para as mulheres.

O Google destacou que os anunciantes podem especificar que seus anúncios sejam exibidos apenas para determinados usuários ou em determinados sites. A empresa permite que seus clientes segmentem seus anúncios com base no gênero. Mas Datta e seus colegas também sugeriram que o algoritmo do Google poderia ter determinado ele mesmo que os homens são mais adequados a posições executivas, tendo aprendido com o comportamento de seus usuários: se as únicas pessoas vendo e clicando em anúncios de empregos bem remunerados são homens, o algoritmo aprenderá a mostrar esses anúncios apenas aos homens.

5. Facebook falsamente alimenta a intifada

Algumas vezes, a inteligência artificial aumenta o preconceito humano. Em outubro de 2017, a polícia de Israel prendeu um trabalhador palestino que havia postado uma foto dele no Facebook posando junto a um trator no qual estaria escrita a legenda "Ataque-os" em hebraico. Só que ele não fez isso: o árabe para "Bom dia" e "Ataque-os" é muito semelhante, e o programa de tradução automática do Facebook escolheu a versão errada. O homem foi interrogado por várias horas antes de alguém detectar o erro. O Facebook foi rápido em pedir desculpas.

| Ver mais notícias sobre os temas: | |||

Ética | Relacionamentos | Sentimentos | |

| Ver todos os temas >> | |||

Descobertos efeitos magnéticos na origem da vida

Do autismo ao Alzheimer, a culpa pode estar no metabolismo do cérebro

Spray nasal dá resultados promissores contra apneia do sono

Não é a escola que é boa, os alunos bons é que se matriculam lá

Conheça o seu ageótipo, que determina como será seu envelhecimento

Casca da jabuticaba combate síndrome metabólica e obesidade

Usar cannabis recreativamente protege contra declínio cognitivo, diz pesquisa

Entra em vigor autorização eletrônica para doação de órgãos

Cuidado com os excessos no uso de suplementos de vitamina D

Mapas corporais mostram onde você sente a música

Guardar produtos químicos em casa aumenta risco de ELA

Câncer de tireoide tem forte sobrediagnóstico em regiões mais ricas

Animais têm personalidade: Nem mesmo vermes comportam-se do mesmo jeito

Cientistas do Brasil e da Índia criam tratamento contra tumores sólidos

Suco de repolho roxo trata doenças inflamatórias intestinais

Antibióticos revelam uma nova maneira de combater o câncer

Extrair DNA de animais fossilizados em âmbar ainda é ficção científica

Creme alimentar com ingredientes da dieta mediterrânea dispensa conservantes

Feijão-de-corda gera alimentos industrializados de alta qualidade

Yacon é fonte de nutrientes para prebióticos e alimentos funcionais

Censo 2022: Por que várias cidades brasileiras tiveram diminuição da população?

Brasil tem primeiro caso de gripe aviária em aves domésticas

Brasil decreta emergência zoossanitária devido à gripe aviária

Proibido o uso de animais em pesquisas de cosméticos e higiene pessoal

Anvisa aprova medicamento para tratamento de internados com covid-19

ANS lança campanha contra cesarianas desnecessárias

A informação disponível neste site é estritamente jornalística, não substituindo o parecer médico profissional. Sempre consulte o seu médico sobre qualquer assunto relativo à sua saúde e aos seus tratamentos e medicamentos.

Copyright 2006-2024 www.diariodasaude.com.br. Todos os direitos reservados para os respectivos detentores das marcas. Reprodução proibida.